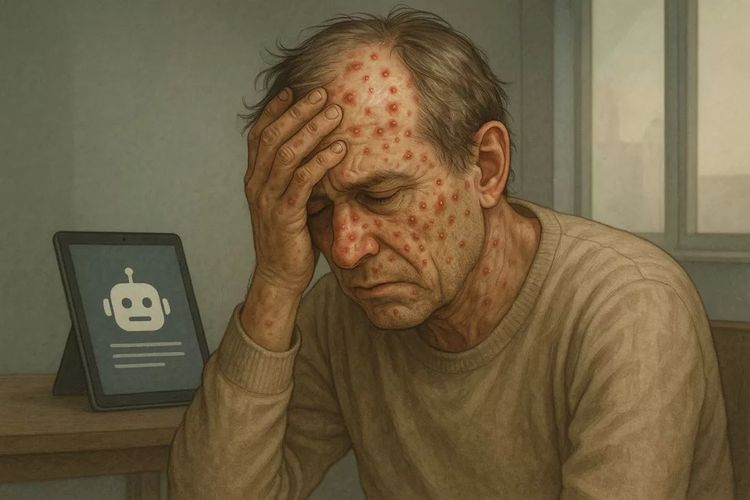

Pengalaman Pria Berusia 60 Tahun yang Mengikuti Saran ChatGPT dan Akhirnya Dirawat di Rumah Sakit

Seorang pria berusia 60 tahun di Amerika Serikat (AS) harus menjalani perawatan selama tiga minggu di Instalasi Gawat Darurat (IGD) setelah mengikuti saran dari chatbot AI milik OpenAI, ChatGPT. Peristiwa ini terjadi setelah ia meminta bantuan dari AI untuk mengubah gaya hidupnya, termasuk mengganti asupan garam dapur yang biasanya mengandung natrium klorida (NaCl).

Menurut Pusat Pengendalian dan Pencegahan Penyakit AS (CDC), konsumsi garam berlebihan dapat meningkatkan tekanan darah dan memicu risiko penyakit serius seperti serangan jantung dan stroke. Hal ini mungkin menjadi alasan pria tersebut ingin mengganti natrium klorida dengan bahan lain. Setelah berkonsultasi dengan ChatGPT, ia menemukan bahwa natrium klorida bisa diganti dengan natrium bromida.

Ia pun langsung membeli produk yang mengandung natrium bromida secara online dan mengonsumsinya selama tiga bulan tanpa rekomendasi medis. Sayangnya, natrium bromida tidak direkomendasikan untuk konsumsi manusia. Dulu, senyawa ini digunakan sebagai obat penenang dan penghilang gejala kejang pada abad ke-19 hingga awal abad ke-20. Namun, saat ini, senyawa tersebut hanya digunakan dalam obat anti kejang untuk hewan peliharaan seperti anjing dan kucing.

Selain itu, natrium bromida juga sering ditemukan dalam berbagai produk kebersihan, termasuk produk perawatan kolam renang. Menurut National Library of Medicine (NLM), senyawa ini berbahaya bagi manusia jika dikonsumsi dalam jangka panjang. Efek yang muncul bisa berupa gangguan sistem saraf dan kulit.

Kondisi Memburuk dan Diagnosa Bromisme

Setelah tiga bulan mengonsumsi natrium bromida, kondisi pria tersebut semakin memburuk. Ia kemudian dilarikan ke IGD rumah sakit. Keluhan awal yang dialami adalah rasa haus ekstrem, kelelahan, halusinasi, serta ruam di kulit. Meski merasa haus, ia menolak air yang diberikan karena takut airnya tidak bersih.

Ia juga menyampaikan kepada dokter bahwa sedang menjalani pola makan ketat, tetapi tidak menyebutkan bahwa ia mengikuti saran dari ChatGPT. Di hari pertama di IGD, pria ini mengalami halusinasi berat dan perilaku aneh, termasuk mencoba kabur karena ketakutan berlebih. Dokter akhirnya memberikan obat penenang dan melakukan pemeriksaan laboratorium lebih lanjut.

Hasil uji laboratorium menunjukkan bahwa pria ini mengalami defisiensi vitamin penting dan kadar bromida di tubuhnya mencapai 1.700 mg/L, jauh di atas angka normal yang sekitar 0,9–7,3 mg/L. Untuk mengurangi kadar bromida, dokter memberikan cairan dan elektrolit agar senyawa berbahaya ini keluar melalui urin.

Pria ini dirawat selama tiga minggu dan akhirnya didiagnosis mengidap Bromisme, sebuah penyakit langka akibat paparan bromida dalam jangka waktu lama.

ChatGPT dan Kesalahan Saran

Selama masa perawatannya, pria tersebut akhirnya jujur kepada dokter bahwa ia menggunakan ChatGPT dan mengikuti saran mengganti natrium klorida dengan natrium bromida. Para dokter tidak tahu persis apa isi percakapan antara pasien dan ChatGPT, karena mereka tidak memiliki akses ke percakapan tersebut.

Namun, studi dari “Annals of Internal Medicine: Clinical Cases” menunjukkan bahwa ChatGPT memang menyarankan penggunaan natrium bromida. Meskipun demikian, AI ini tidak memberikan peringatan kesehatan yang jelas tentang bahaya senyawa tersebut.

Perkembangan Terbaru pada ChatGPT

Model AI terbaru, seperti GPT-5, tampaknya telah belajar dari kesalahan sebelumnya. Ketika ditanya apakah natrium bromida bisa digunakan sebagai pengganti garam, ChatGPT memberikan respons yang jelas bahwa senyawa ini tidak aman untuk dikonsumsi harian dan bisa menyebabkan komplikasi kesehatan.

ChatGPT juga menyarankan pengguna untuk menggunakan garam rendah natrium atau bumbu non-garam sebagai alternatif. OpenAI menegaskan bahwa model terbaru ini lebih spesifik dan penuh dengan peringatan kesehatan.

Pentingnya Konsultasi Medis

Meskipun ChatGPT semakin pintar, OpenAI menekankan bahwa AI tidak boleh digunakan sebagai pengganti tenaga medis profesional. Chatbot hanya bisa menjadi mitra dalam membantu pemahaman atau mengajukan pertanyaan yang tepat, namun keputusan akhir tetap ada pada dokter.

OpenAI juga menegaskan bahwa ChatGPT tidak ditujukan untuk diagnosis atau perawatan kondisi kesehatan tertentu. Mereka menyarankan pengguna untuk tetap mempertimbangkan saran dari penyedia layanan kesehatan sebelum membuat keputusan medis.

Kesimpulan

Peristiwa yang dialami pria berusia 60 tahun ini menjadi contoh penting bahwa saran dari AI, meskipun terlihat masuk akal, belum tentu aman atau teruji klinis. Penggunaan AI dalam bidang kesehatan harus dilakukan dengan hati-hati dan selalu didampingi oleh ahli medis.